”Vi vet med stor säkerhet hur artificiell

allmän intelligens (AGI) ska konstrueras.”

Sam Altman vd, Open AI

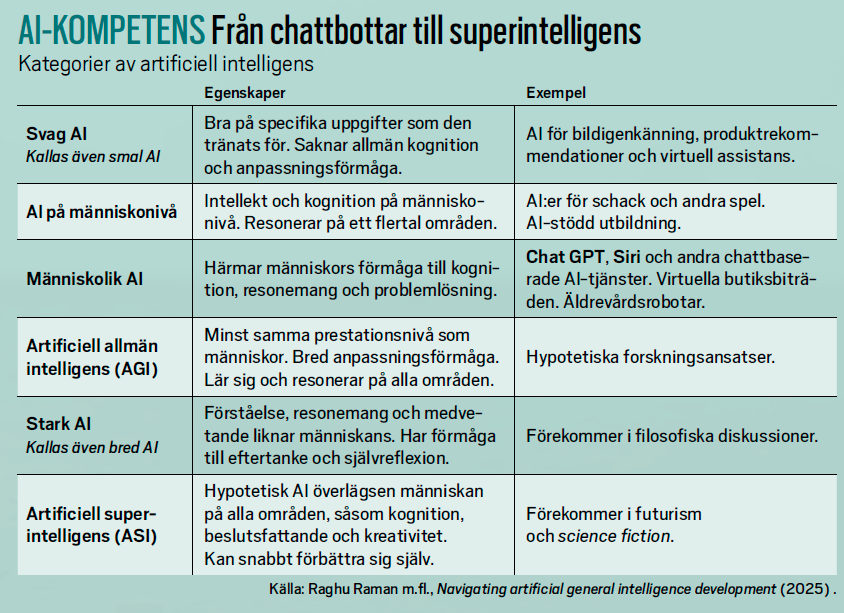

En maskin minst lika bra som människan på det mesta – det är en vanlig definition av artificiell allmän intelligens (artificial general intelligence, AGI). Open AI-medgrundaren Sam Altman bloggar om en ”gigantisk välståndsökning” när superintelligenta verktyg genererar idel forskningsrön och innovationer.

Huruvida dagens tongivande AI-teknik leder till AGI är omstritt. När den amerikanska forskningsorganisationen AAAI nyligen frågade 475 AI-proffs (de flesta akademiker) var tre av fyra skeptiska till att det räcker med fortsatt uppskalning av maskininlärningsbaserade metoder.

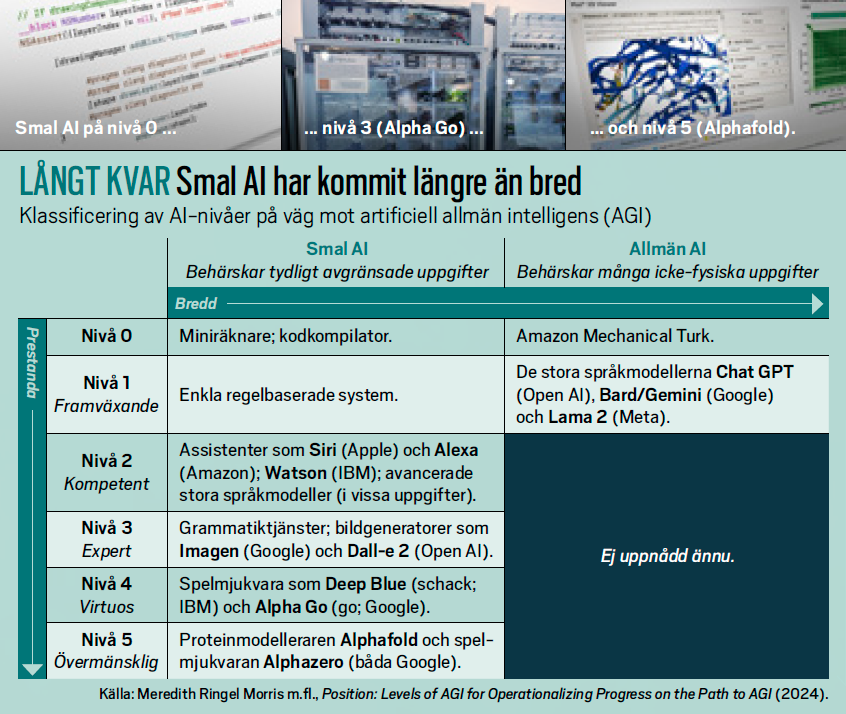

AGI har två dimensioner: prestanda (att tänka snabbt och ta in enorma datamängder) och mångsidighet (tankeförmågan ska vara bred och flexibel, som vår egen). Så kallad smal AI brädar redan människor i en rad olika specialtillämpningar, såsom att 3D-modellera proteiner. Men inte ens AI-jättarnas stora språkmodeller har i dag nått bortom första steget på en femgradig AGI-skala, presenterad av forskare på Google-bolaget Deep Mind (se tabell nedan).

De konkreta AGI-kriterierna varierar. Microsofts AI-chef Mustafa Suleyman tycker att en AGI ska kunna tiofaldiga ett kapital om 100 000 dollar under ett par månader. Andra, som Apples medgrundare Steve Wozniak, efterlyser vardagsfunktionalitet (”koka kaffe-testet”). Det gör även den amerikanske AI-profilen Gary Marcus, som påpekar att stökiga hemmiljöer är ett klart knepigare AI-test än att köra bil i välstrukturerade trafiksituationer.

AI-butlern Mobile Aloha, från våren 2024, är en människostor maskin med två ledade kameraförsedda griparmar, monterade på ett mobilt underrede för lagerrobotar. Mobile Aloha tränades på sju arbetsuppgifter, däribland att steka en räka, ställa in en gryta i ett skåp och torka upp vinspill. Projektet på Stanford-universitetet i USA i samarbete med Deep Mind har en uttalad lågbudgetprofil där hårdvarukostnaden stannade vid 32 000 dollar.

Visionen är att smarta hushållsrobotar ska lära sig vad de behöver av videomaterial och liknande, men än så länge krävs omfattande mänsklig stödundervisning, där exempelvis lärarna till Teslas humanoida robot Optimus tar på sig dräkter för motion capture (rörelsefångst). Mobile Aloha tränades dels på data från en stationär föregångare, dels genom puppeteering – människor gick då bakom roboten och demonstrerade rörelserna med en separat uppsättning griparmar.

Superlativen haglade, men Youtubefilmer indikerar att vi får steka våra räkor själva en tid till. Träningen fick upprepas 50 gånger per uppgift (vissa moment klarades hyggligt utan sådan manuell träning, andra – som att öppna en vattenkran – inte alls). När Mobile Aloha donar på egen hand är valhäntheten påtaglig. Till synes oförklarligt har roboten ned en kastrull ur köksskåpet, serverar räkan bredvid tallriken, eller knipsar av vinglaset (läs Mobile Aloha-rapporten här).

Felen är instruktiva, anser Peter Gärdenfors, professor i kognitionsvetenskap vid Lunds universitet. Hans bok Kan AI tänka? (Fri tanke, 2024) belönades med förlaget Natur & Kulturs debattbokspris i maj 2025.

– Mobile Aloha tränas på visuell information, den gör saker i miljöer som visuellt liknar träningsmaterialet. Jämfört med en industrirobot kan Aloha generalisera lite mer och anpassa sina rörelser till en delvis ny situation. Men Aloha förstår inte alls de krafter som verkar och hur de påverkar handlingarna. Redan ett litet barn lär sig det väldigt snabbt, och skulle aldrig sticka stekspaden under stekpannan, som Aloha gör, säger Peter Gärdenfors.

Människans hjärnkraft är rotad i den fysiska miljön, som tidigt ger oss bra koll på kausalsamband – vi tänker i termer av orsak, verkan och handlingsmöjligheter,

förklarar Peter Gärdenfors i sin bok.

– Vanliga mänskliga vardagsaktiviteter är fortfarande oerhört svåra att simulera eller reproducera med artificiella medel. Vi människor har tryckreceptorer och så kallad proprioception, där vi är medvetna om våra kroppsdelars positioner. Det är väldigt viktigt för att vi ska lära oss orsakssamband, säger Peter Gärdenfors.

– För att kunna gå längre måste systemen kunna förstå, tolka och i princip känna de krafter som verkar i världen. Att de förstår hur krafter verkar i vardagssammanhang är för mig en nyckel till fortsatt utveckling.

Peter Gärdenfors påpekar att dagens AI:er opererar utan kognitiva modeller – de extraherar sannolikheter ur träningsmaterial, men har ingen förståelse för hur världen ser ut.

– Många tror att människans hjärna fungerar med ögonen som kameror – att den tar in bilden, bearbetar den och översätter den till en handling. Men så är det inte. Vi tar inte bara in data utan tolkar dem. Synsystemet separerar konturer och skiljer ut objekt från bakgrunden. Vi vet av erfarenhet att vissa saker går att lyfta, flytta på och så vidare, och förstår hur man interagerar med objekt, även om det inte framgår av bilden. Hjärnan är förberedd för att lära sig detta.

Kan förmågan ges till en mjukvara?

– Mjukvara räcker inte. En riktigt bra kognitiv modell kräver interaktion mellan perception och handling. När vi gör saker med händerna är det en loop mellan ögonen och handen som hela tiden justerar sig. Att bygga in detta i mjukvarusystem är jättesvårt. Du behöver ha en kropp som agerar i världen för att kunna lösa enkla problem som att städa golvet eller att byta en blöja.

AI har gått från tidiga språk- och logikbaserade modeller till dagens neurala nätverk med djupinlärning, som är grunden för Chat GPT och de andra språkmodellerna. Men hjärnan är ingen dator, betonar Peter Gärdenfors.

– Det är en myt att om du bara har en tillräckligt stor datormodell i form av ett neuralt nätverk, så kan du ladda ner en hjärna. De största språkmodellerna har lika många ”neuroner” som det finns i hjärnan, men de blir inte en hjärna för det. Hjärnan är oerhört mycket mer komplex än neurala nätverk någonsin kommer

att bli, med sådant som signalsubstanser, syretillförsel och elektromagnetiska fält.

Meta-grundaren Mark Zuckerberg efterlyser AI med intuition. Du talar i din bok om ”omdöme”. Vad är det?

– En skicklig yrkesman, såsom en snickare, kock eller sömmerska, har en enorm erfarenhet – inte minst kroppslig – av att lösa problem. De får en intuition om hur ett problem kan lösas, men kan inte verbalisera den. Med den definitionen kan datorsystem mycket väl ha intuition: De har löst många problem, och kan välja den mest sannolika lösningen. Men människor kan vara mer kreativa, de inser att en ny situation har nya faktorer som avviker från mönstren. Därför har skickliga yrkespersoner en mycket rikare intuition än vad ett AI-system kan få. Människor förstår ofta vad som är bra eller dåliga lösningsansatser, säger Peter Gärdenfors.

– Man försöker att bygga in sådan metakognition i vissa system, och de stora språkmodellerna presenterar materialet på ett annat sätt än tidigare, som passar in bättre med vad vi vill ha. Men att få till den typ av självreflexion som vi människor använder ibland när vi bedömer om en lösning är rimlig eller ej är mycket besvärligt.

Varför skrev du din bok?

– Jag var lite trött på sådana som Max Tegmark och Nick Bostrom, som säger att AGI tar över världen snart. Hajpen kring de stora språkmodellerna säger att de är väldigt intelligenta system. Som kognitionsvetare vill jag säga att människors och djurs intelligens omfattar så väldigt mycket mer än vad som kan hanteras av de här systemen. De stora språkmodellerna är väldigt bra verktyg för olika uppgifter, snarare än självständiga intelligenser. De kommer inte att ta över världen. Det är väldigt långt kvar till AGI.

Reporter: Joakim Braun

Denna artikel från sommarutgåvan av DNB Carnegie Private Bankings kundmagasin Insikt publicerades i juni 2025. Vill du veta mer om vårt erbjudande? Boka ett möte här.